Nur was man kennt, kann man schützen. Unter diesem Leitsatz wurde der Bodensee in den Jahren 2012 bis 2015 neu vermessen. Die Ergebnisse des Projekts „Tiefenschärfe – Hochauflösende Vermessung Bodensee“ stellte Martin Wessels, Geologe am Institut für Seenforschung, jetzt bei der Landesgartenschau in Überlingen vor. Kombiniert wurden die hochauflösenden Daten eines Fächerecholotes für Wassertiefen ab fünf Metern sowie eines Laserscanners für die Flachwasserzone und die Uferbereiche. Erstere wurden von dem Boot Kormoran aus gewonnen, Letztere von einem Flugzeug aus. Es handelt sich um die größte Datensammlung, die den Wissenschaftlern jemals zur Verfügung stand, um Strukturen im Bodensee zu verstehen und deren Veränderung zu untersuchen. Aber auch Verwaltungen sollen von den Basisdaten für ihre Planungen profitieren.

Erste Messungen 1825 und 1826

Erstmals vermessen wurde der See in seinen Tiefen in den Jahren 1825 und 1826. Eckpunkte der Ergebnisse von Johann Gasser aus dem Jahr 1826 führte Wessels in seinem Vortrag auf. Vorgenommen wurden „Lothungen nach 13 Richtungen“ und Messungen an „nicht weniger als 333 Stellen“. Laut dem Geologen kam Gasser auf eine Seefläche von neuneinhalb Quadratmeilen und eine größte Tiefe von 964 Fuß. Nicht alles lässt sich heute noch nachvollziehen, für die Wissenschaftler ergeben sich aber wichtige Hinweise auf den früheren Zustand des Bodensees und die Zusammenarbeit der Anrainerstaaten.

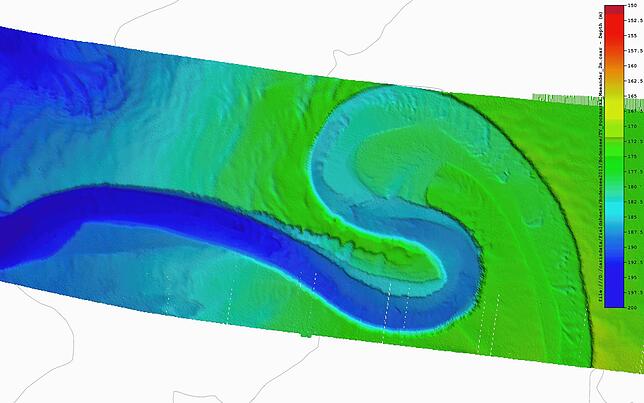

Im Jahr 1893 entstand die sogenannte Zeppelin-Karte. Eine von den fünf Uferstaaten eingesetzte Kommission hatte diese in Auftrag gegeben. Hier waren es schon 11 147 Lotungen, die mithilfe eines „Sondirapparats“ ausgeführt und mit Beobachtungen von Naturwissenschaftlern kombiniert wurden, wie die Internationale Gewässerschutzkommission für den Bodensee (IGKB) in ihrem Bericht schreibt. Martin Wessels erklärte: Bei der Zeppelin-Karte sei erkannt worden, „wie wichtig die gemeinsame Arbeit ist, der gemeinsame Schutz des Bodensees“. Der IGKB zufolge wurde die Zeppelin-Karte als Grundlage für die beginnende Erforschung des Sees auf vielen wissenschaftlichen Gebieten gesehen. Während Johann Gasser den Großteil des Seegrunds noch für schlammig hielt, wurden 1893 bereits Strukturen identifiziert. So zum Beispiel der Mäander vor Langenargen, eine Flussschlinge am Seegrund. Lange galten die Zeppelin-Karte und ihre Ableitungen.

1990 gab es dann eine Echolot-Vermessung sowie Fächerecholot-Messungen in den Jahren 2008 und 2009. „Bei der Vermessung 1990 wurde ein hoher Aufwand betrieben: Auf circa 3000 Kilometern Fahrtstrecke wurden über 900 000 Datenpunkte gemessen. Wegweisend war schon damals das Herstellen eines dreidimensionalen Geländemodells, das in den Folgejahren für vielfältige Fragestellungen verwendet wurde“, erläutert die IGKB. Als maximale Tiefe seien 253,55 Meter, bezogen auf einen mittleren Wasserstand von 395,45 Meter angegeben worden.

Neue Technik mit enormem Potenzial

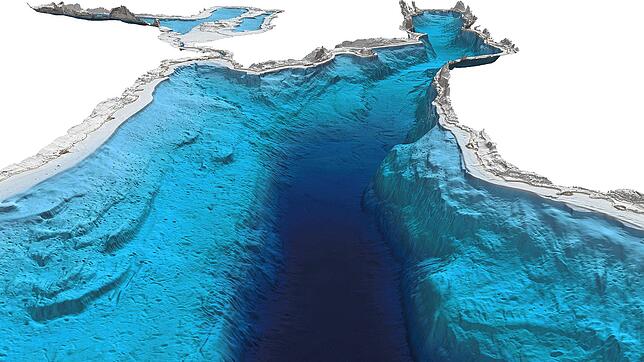

Computer-Hardware und -Software, GPS-Technik und mobile Fächerecholote eröffneten den Experten am Ende des 20. Jahrhunderts schließlich neue vielfältige Möglichkeiten. Die Vermessung einzelner Gebiete habe das enorme Potenzial der Technik gezeigt, schrieb Wessels 2010. Im Überlinger Kursaal berichtete er: Das sei so ein bisschen der gedankliche Startschuss für das Projekt „Tiefenschärfe“ gewesen. Auf einer Strecke von 5608 Kilometern wurden mehr als 7,2 Milliarden Tiefenpunkte mit dem Fächerecholot erfasst. Die Bootsführer absolvierten teils Schichten mit über zwölf Arbeitsstunden.

Wessels erklärte: „Wir haben nicht nur den Seegrund vermessen, sondern auch, was im Wasser ist.“ Etwa Stellen, wo Methan austritt. Das sei klimarelevant, sagte Wessels. Ebenfalls erkennbar sind Fischschwärme. Der tiefste Punkt des Sees wurde von den Wissenschaftlern auf 251,1 Meter festgelegt. Ein rein statistischer Wert, so Wessels: „Jede Technik hat einen kleinen immanenten Fehler.“ Die Gewässervermessung aus der Luft brachte zwölf Milliarden Datenpunkte sowie 22 000 Luftbilder.

In der Flachwasserzone fand man Strukturen, die vorher nicht bekannt waren, erzählte der Geologe. Prominenz haben die „Hügeli“ erlangt, die auf der Schweizer Seite zwischen Bottighofen und Romanshorn gefunden wurden, 170 Steinhaufen, die vermutlich aus der Pfahlbauerzeit stammen.

Datenmengen fordern Software

Im Wasser war herausfordernd, beispielsweise die genaue Lage der Kormoran und äußere Einflüsse wie die Wassertemperatur stets in die Ergebnisse mit einzubeziehen. Auch hatte die Software Schwierigkeiten, die große Menge an Daten zu verarbeiten. „Sie kommt aus der Marine, und ist nicht darauf ausgelegt, dass sich ein Boot vier, fünf Monate in einem Bereich aufhält“, erläuterte Martin Wessels. Mit den per Flieger erhobenen Datenmengen hatte die gewählte Software ebenso zu kämpfen. Entstanden ist ein 3D-Modell, das detaillierte Einblicke wie in eine andere Welt ermöglicht. Sensible Daten seien maskiert worden, sagte Wessels. Etwa der Fundort des Schaufelraddampfers Jura, „um dem Denkmalschutz gerecht zu werden“, oder die Leitungen der Trinkwasserentnahme.

Der am besten vermessene See der Welt

Mit über 19 Milliarden Daten sei der Bodensee der am besten vermessene See der Welt, sagte Martin Wessels schmunzelnd. Folgeprojekte wurden noch während der Laufzeit von „Tiefenschärfe“ angegangen. Forscher des Fraunhofer-Instituts für Energiewirtschaft und Energiesystemtechnik versenkten im Jahr 2016 zum Beispiel eine Betonkugel vor Überlingen. Diese sollte als Prototyp die Stromspeicherung unter Wasser testen. Umgesetzt werden aber nicht nur Forschungsprojekte mit einer speziellen Fragestellung. Die Wissenschaftler beobachten und treffen Annahmen – wie zu den Auswirkungen des Schiffsverkehrs auf den Seegrund. Erforscht werden gleichermaßen die Effekte des Klimawandels auf den Bodensee und Baumaßnahmen angepasst. „Wir haben einen guten Grund, ihn (den See) zu schützen und seine Resilienz nicht zu überbeanspruchen“, sagte Wessels.